¿Alguna vez te has preguntado cómo funciona CHAT-GPT? El lenguaje de los expertos es demasiado especializado, por lo que, añadimos apartados resumiendo y simplificando el texto completo.

Actualmente podemos escuchar en diferentes medios de comunicación el término ChatGPT, el cual se encuentra relacionado con un modelo de Inteligencia Artificial basado en la arquitectura denominada Transformers, la cual fue presentada en un paper de investigación de Google que se publicó a finales del año 2017, cuyo título es: “Attention is All You Need”, a partir de la publicación de dicho trabajo se presentaron diferentes modelos basados en esta tecnología y cuyo modelo más conocido actualmente es el denominado GPT-4, iniciando originalmente en GPT-1 hasta llegar a GPT-4, que es el modelo en que se basa ChatGPT.

“Un modelo de Inteligencia Artificial es una herramienta que se utiliza para que aprendan a hacer tareas específicas; son como cerebros electrónicos que se les enseñan a reconocer patrones y a tomar decisiones basadas en esos patrones.”

“La arquitectura denominada Transformers es una técnica de aprendizaje automático utilizada en Inteligencia Artificial para procesar lenguaje natural, es decir, el lenguaje que utilizamos las personas para comunicarnos.”

La inteligencia artificial ha permitido desarrollar diferentes aplicaciones en diferentes ámbitos de las ciencias computacionales como son: visión por computadora (figura 1), reconocimiento de voz, generación de audio o imágenes automáticamente, o bien, aplicaciones en el procesamiento del lenguaje natural.

Fig. 1. Visión por computadora

Es dentro del procesamiento del lenguaje natural (NLP) donde queremos ahondar un poco el uso de la arquitectura de Transformers, enfocándonos en la detección de información relacionada con la temática de un texto, ya que este es un problema dentro del desarrollo de sistemas de información orientados a la clasificación de textos. Antes de la aparición de las arquitecturas basadas en Transformers, se utilizaban diferentes algoritmos basados en la semántica latente o implícita dentro de un texto, principalmente Latent Semantic Analysis (LSA) [1] y Latent Dirichlet Allocation (LDA) [2], que permiten generar diversos grupos temáticos a partir de un conjunto de textos de entrada, con la aplicación de estos algoritmos se obtienen diferentes representaciones espaciales similares a planos cartesianos de múltiples dimensiones, en los cuales se proyectan los diferentes documentos, obteniendo con ello sus coordenadas en esos planos cartesianos, para posteriormente, mediante una tarea de clasificación, ubicar los documentos que queremos ubicar en una temática a priori conocida.

A la aparición de los modelos de Transformers se comenzó a generalizar su uso dentro de las tareas de clasificación temática en el NLP, los cuales, a diferencia de los algoritmos anteriormente mencionados, se basan en el uso de los modelos de lenguaje [4, 5]. En estos Transformers es importante que la información de entrada se encuentre como en el texto original, es decir, en forma de enunciados y/o párrafos, a diferencia de las herramientas de clasificación utilizadas antes de la aparición de los Transformers, la información se transformaba en una representación vectorial, la cual podía ser tf, tf-idf o binaria [3], principalmente, pero para los modelos de lenguaje son importantes las secuencias de las palabras, ya que a partir de ellas se generan espacios semánticos o de embeddings. Es por ello, que se han desarrollado herramientas [6, 7] que permiten extraer los enunciados más característicos, noun phrases o chunks, [8] utilizando un modelo de lenguaje, basadas inicialmente en la tecnología de redes neuronales y posteriormente, haciendo uso de arquitecturas de Transformers, como por ejemplo las librerías Spacy [6] o Stanza [7].

“Los embeddings son una técnica utilizada en el procesamiento del lenguaje natural en la Inteligencia Artificial para entender el significado de las palabras y frases.”

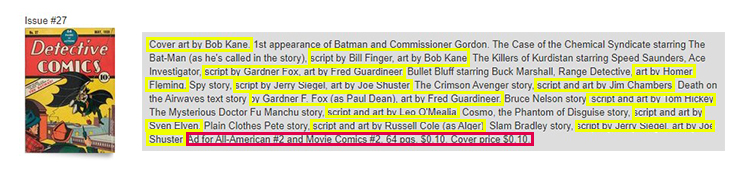

Una vez conocidos los algoritmos utilizados antes de los Transformers, queremos mencionar un trabajo que desarrollamos para observar las mejoras que se obtienen utilizando los denominados Transformers con respecto a los algoritmos usados antes de su aparición, para ello, antes de la utilización de los algoritmos y de los Transformers, se tuvo que identificar un corpus de documentos que fuera temático, eligiéndose información relacionada con los comics o historietas y se eligieron dos personajes famosos que son temáticamente diferentes, siendo los elegidos Superman y Batman ambos propiedad de DC Comics ©, siendo el primero un extraterrestre con habilidades y poderes sobrehumanos, y el segundo un hombre ordinario con habilidades desarrolladas. Una vez elegida la temática procedimos a obtener la información, la cual fue descargada en forma manual del sitio www.mycomicshop.com, una tienda especializada en la compra y venta de comics y que provee la descripción de las revistas que ofrece, con ello se descargaron alrededor de 1200 descripciones que corresponden a los primeros 300 números para cada una de las revistas Detective Comics y Batman, para el caso de Batman y Action Comics, y Superman para el caso del tema Superman. En la figura 2, se muestra la descripción para el cómic Detective Comics #27 publicado en 1939, en esta figura se puede observar, marcado en color amarillo, la información relativa con los diferentes autores de las historias que se incluyen, en color rojo la información relacionada con la revista y sin marcar información relacionada directamente con el contenido del cómic.

Fig. 2. Descripción del cómic Detective Comics #27 (1939)

Una vez descargado el corpus o conjunto de documentos, se identificaron algunos términos que no están relacionados con el contenido de un cómic, como son los nombres de los autores, el precio de la revista, fecha de publicación, signos que puedan ser considerados ruido, entre otros.

Y así, con la información adecuada procedimos a generar un conjunto de experimentos que permitieron comparar los resultados arrojados por un modelo de Transformer, al momento que desarrollamos este trabajo se eligió un modelo BERT que era uno de los más utilizados por los grupos de investigación, antes de la interrupción de ChatGTP, con los algoritmos antes utilizados que llamaremos modelos tradicionales.

“El modelo BERT utiliza técnicas de atención y codificación para entender el contexto completo de un texto, incluyendo las palabras que lo preceden y lo siguen.”

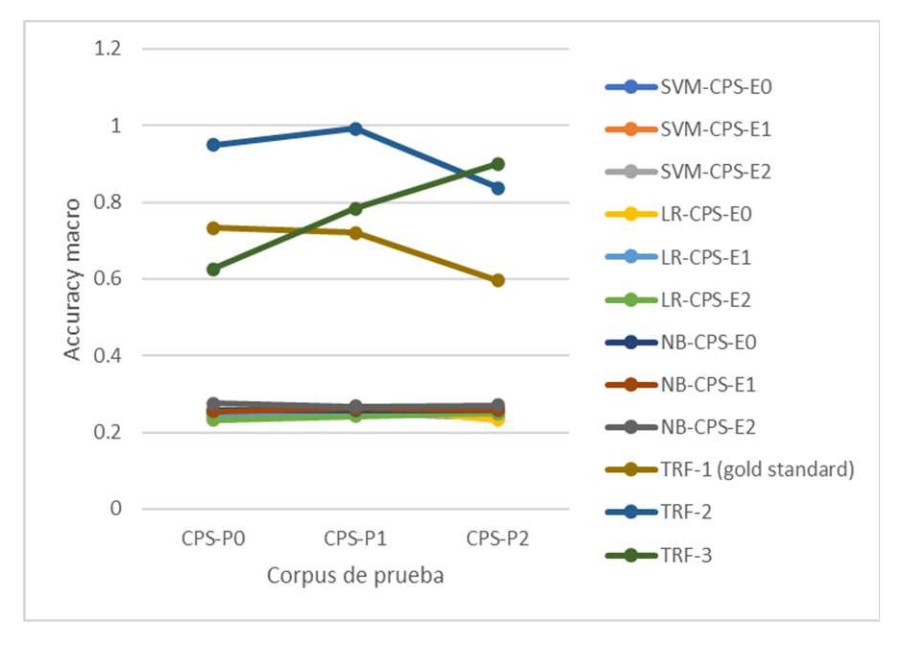

En los diferentes experimentos realizados se observa que el valor máximo obtenido en las diferentes pruebas utilizando Transformers es del 99 % y el mínimo del 59 %, mientras que en el caso de los algoritmos tradicionales el valor está en un promedio del 26 %, esto quiere decir que el error del Transformer en el mejor de los casos es sólo 1 en cada 100. De 100 descripciones de cómic que se le presentan identifica adecuadamente cuál pertenece a una descripción de Superman y cuál a una de Batman, y en el peor de los casos ofrece un rendimiento similar a un volado ya que se puede generalizar a que acierta una de cada 2 preguntas, no así en el caso de los algoritmos tradicionales, ya que en este caso sólo acierta 1 de cada 4 preguntas, es decir, tiene un grado de error más alto. En la figura 3, se muestra como el corpus de entrenamiento utilizado en TRF-2 permite que el Transformer modele adecuadamente el fenómeno y también se obtiene el mejor valor de accuracy (exactitud) que es de 0.992.

Fig. 3. Gráfica de resultados de pruebas

Con ello, observamos que los modelos de Transformers en tareas de clasificación relacionadas con la temática de un conjunto ofrecen mejores resultados que los modelos tradicionales, esto se puede entender ya que para un Transformer es importante el orden de las palabras, al estar basado en el uso de redes neuronales el nivel de granularidad de análisis es variable, ya que la misma arquitectura realiza un análisis más profundo buscando un nivel de granularidad óptimo, a diferencia de los modelos tradicionales que pueden ser más identificados como probabilísticos o estadísticos en los cuales para realizar un análisis con diferentes granularidades se debe realizar manualmente lo que en un modelo Transformer es un poco más automático. Por otro lado, esto nos lleva a cuestionarnos la manera en cómo el modelo de Transformer transforma los textos en un espacio denominado embedding y la manera en la cual la misma arquitectura, a partir de esta transformación, puede ubicar correctamente los textos que conforman el corpus con el que se entrena, sin embargo, su performance nos permite entender por qué es una tecnología que a pesar de necesitar una alta cantidad de recursos informáticos se está convirtiendo en una tecnología ampliamente utilizada que depende principalmente de la calidad de los datos con los que se entrena el modelo Transformer, los modelos tradicionales también dependen de los datos de entrada, pero la arquitectura desarrollada por Google inicialmente o las mejoras realizadas en BERT o ChatGPT permite que los Transformers superen generalmente a los modelos tradicionales.

Si quieres leer el artículo completo puedes verlo en el siguiente enlace: https://doi.org/10.13053/cys-26-3-4187 de los autores: Dr. Jorge Víctor Carrera-Trejo y Dr. Rodrigo Cadena Martínez.

Rodrigo Cadena Martinez

Redactor en EXPOSTISC, MSc, PhD, Gerente de Diseño Curricular de Posgrado, Investigador, Desarrollador de Proyectos y Docente. En mis ratos libres disfruto pasar tiempo con mi familia, veo series y películas, juego futbol, leo y programo.

Todos los derechos reservados IEXE 2022 Aviso de Privacidad Contacto

Excelente artículo, me queda claro el nuevo ámbito tecnológico al cual la humanidad se enfrenta, felicitaciones a los autores

Muchas gracias por tus comentarios Edwin, hacemos este contenido precisamente para ustedes.